Mistral 7b Mixtral 8x7b Explained Models Embeddings Use Cases Performance

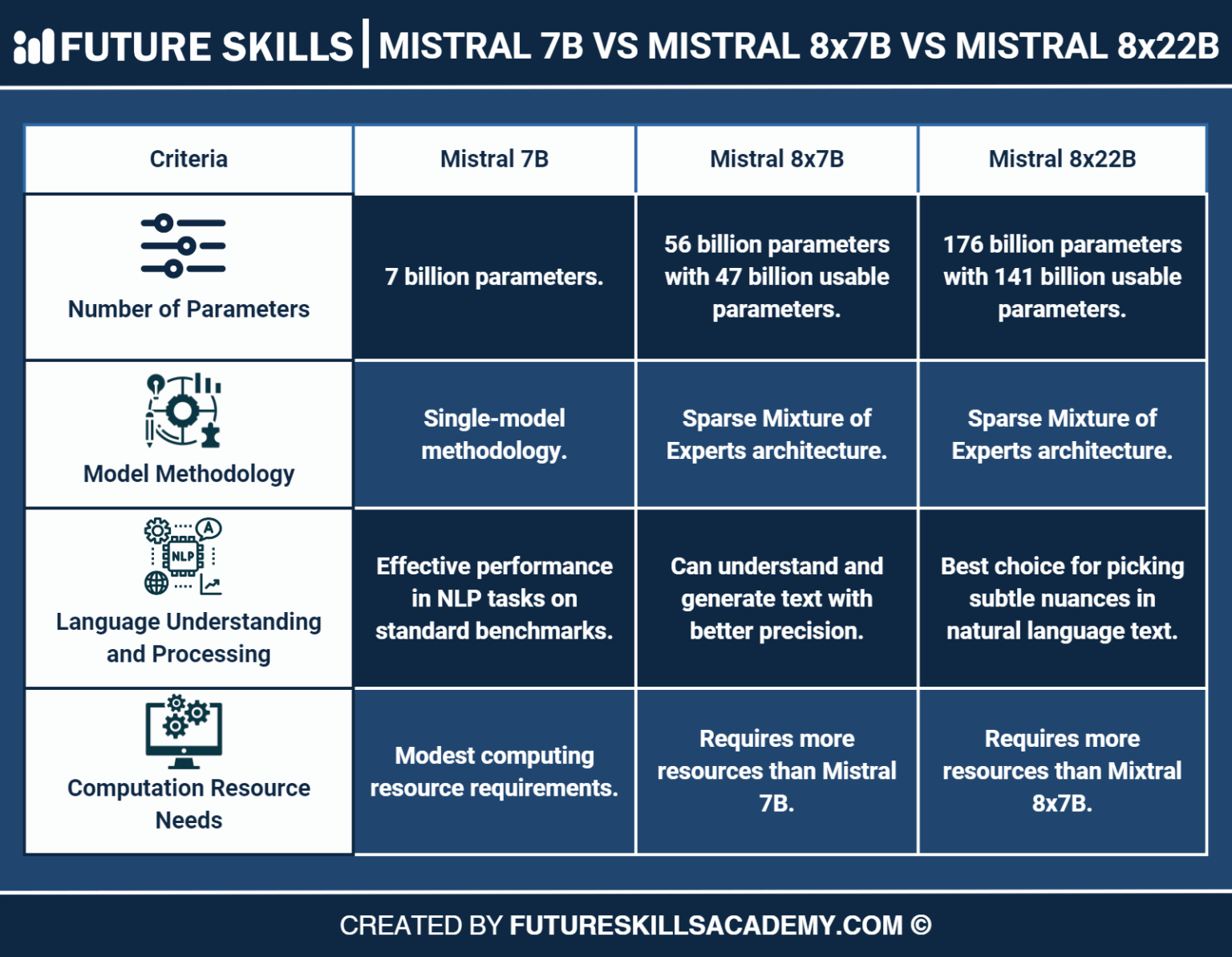

Mistral Vs Mixtral Comparing The 7b 8x7b And 8x22b Llms Future 4. 在输出代码的方式上,mistral large表现得更不“懒惰”:它不会尝试解释下一步要做什么,而是立即输出相应的代码。 总的来说,这两大语言模型在许多方面有相似之处,但mistral large似乎在效率和代码生成直接性等方面有所优化。. 2024年11月19日,mistral ai发布多模态大模型pixtral large,124b参数量。 2024年11月19日,阿里巴巴 发布 通义qwen2.5 turbo。 2024年11月19日,北大等推出首个多模态推理思考开源模型llava o1,基于llama 3.2 vision模型打造,实现自主“慢思考”推理。.

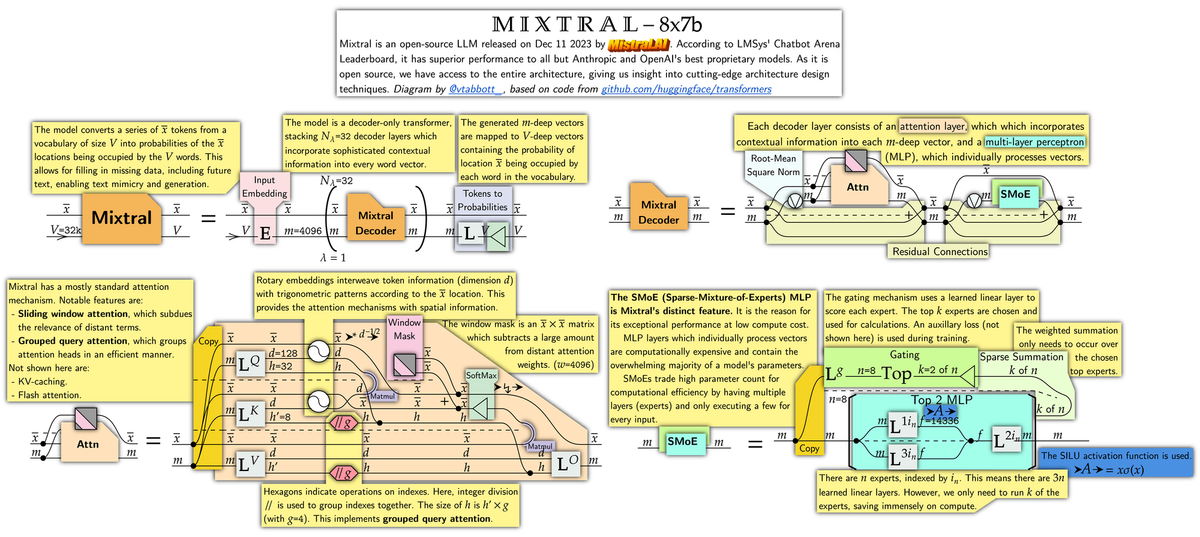

Mixtral 8x7b Instruct V0 1 Model By Mistral Ai Nvidia Nim 感觉都没什么人关注mistral了,非常冷清。 稍微看了一下,确实没有提起太大的兴趣,性能进步有限,而且评测里挑的主要对手是gpt 4o mini、claude 3.5 haiku,都是几个月前的「大龄选手」了,有「拳打南山敬老院」的感觉,稍微新一点的对手选了gemma3,但没有选差不多生态位的phi4和qwen 32b,不太让人. 旋转位置编码(rotary position embedding,rope)是论文 roformer: enhanced transformer with rotray position embedding 提出的一种能够将相对位置信息依赖集成到 self attention 中并提升 transformer 架构性能的位置编码方式。而目前很火的 llama、glm 模型也是采用该位置编码方式。 和相对位置编码相比,rope 具有更好的 外推性. 这样下去,还让大家怎么搞,只能靠蒙的时候,指路明灯出现了:mistral 这个拿了一个多亿美金的浓眉大眼的家伙,一看就是个好人,先是放了个 7b 的模型震撼了一把,接下来嘛,好家伙,直接一个卫星啊! 可以说在开源上,处于 llm 的指引方向。. 在24年11月这个节点,开源大模型中审核极少而且性能极好的是12.6b的mistral nemo及各种微调版本 虽然mistral nemo现在论能力已经明显落后同级别的qwen2.5 14b,但是发布时的24年7月,社区中很多人测评的结果是他能打平很多当时的20b甚至30b模型,中文能力也不弱,放在当下能力也不算落后(关健是22b的.

Mixtral 8x7b A Game Changing Ai Model By Mistral Ai Superannotate 这样下去,还让大家怎么搞,只能靠蒙的时候,指路明灯出现了:mistral 这个拿了一个多亿美金的浓眉大眼的家伙,一看就是个好人,先是放了个 7b 的模型震撼了一把,接下来嘛,好家伙,直接一个卫星啊! 可以说在开源上,处于 llm 的指引方向。. 在24年11月这个节点,开源大模型中审核极少而且性能极好的是12.6b的mistral nemo及各种微调版本 虽然mistral nemo现在论能力已经明显落后同级别的qwen2.5 14b,但是发布时的24年7月,社区中很多人测评的结果是他能打平很多当时的20b甚至30b模型,中文能力也不弱,放在当下能力也不算落后(关健是22b的. Mistral nemo minitron 8b 是 mistral ai 与 nvidia 上个月发布的 mistral nemo 12b 开放模型的微型版本,其尺寸小到足以在 nvidia rtx 驱动的工作站上运行,但却在针对 ai 驱动的聊天机器人、虚拟助手、内容生成器和教育工具的多项基准测试中取得了出色的成绩。. 目前,mistral尚未披露新模型的具体参数,但表示将在3月底的技术峰会上公布详细信息。 这场即将到来的技术盛宴,不仅将检验mistral的技术突破,更将为全球ai开发者提供新的创新起点。. 总结来说,最经济的硬件配置应该是能够在预算范围内提供足够性能的配置。 对于个人微调7b大模型,可以考虑先上1块 4090 gpu,主板可以考虑x12spi tf,这块主板的好处在于两个x16槽位,后续可根据需求扩展;cpu可以搭配xeon gold 6348 6330,256gb(8*32gb ddr4 recc 3200)的内存,以及一个m.2 1tb硬盘,一个4tb. Mistral ocr作为dify应用商店首发插件,实现pdf 图片秒转markdown格式,完美适配大语言模型训练场景。 • 精准解析多类型文档结构.

Mixtral 8x7b A Game Changing Ai Model By Mistral Ai Superannotate Mistral nemo minitron 8b 是 mistral ai 与 nvidia 上个月发布的 mistral nemo 12b 开放模型的微型版本,其尺寸小到足以在 nvidia rtx 驱动的工作站上运行,但却在针对 ai 驱动的聊天机器人、虚拟助手、内容生成器和教育工具的多项基准测试中取得了出色的成绩。. 目前,mistral尚未披露新模型的具体参数,但表示将在3月底的技术峰会上公布详细信息。 这场即将到来的技术盛宴,不仅将检验mistral的技术突破,更将为全球ai开发者提供新的创新起点。. 总结来说,最经济的硬件配置应该是能够在预算范围内提供足够性能的配置。 对于个人微调7b大模型,可以考虑先上1块 4090 gpu,主板可以考虑x12spi tf,这块主板的好处在于两个x16槽位,后续可根据需求扩展;cpu可以搭配xeon gold 6348 6330,256gb(8*32gb ddr4 recc 3200)的内存,以及一个m.2 1tb硬盘,一个4tb. Mistral ocr作为dify应用商店首发插件,实现pdf 图片秒转markdown格式,完美适配大语言模型训练场景。 • 精准解析多类型文档结构.

Understanding Mixtral 8x7b 总结来说,最经济的硬件配置应该是能够在预算范围内提供足够性能的配置。 对于个人微调7b大模型,可以考虑先上1块 4090 gpu,主板可以考虑x12spi tf,这块主板的好处在于两个x16槽位,后续可根据需求扩展;cpu可以搭配xeon gold 6348 6330,256gb(8*32gb ddr4 recc 3200)的内存,以及一个m.2 1tb硬盘,一个4tb. Mistral ocr作为dify应用商店首发插件,实现pdf 图片秒转markdown格式,完美适配大语言模型训练场景。 • 精准解析多类型文档结构.

Comments are closed.